最近はここに書き留めておくことも忘れている始末で、我ながら情けなく思う今日この頃です。

ということで、不定期更新というか最近更新していませんが、JavaScript や VBScript などを紹介していきますのでご参考になれば幸いです。

robots.txt を置くことで検索エンジンのインデックスに特定のページを登録されないようにしたり、サイトマップファイルをクローラーに教えてあげることが出来ます。

robots.txt 自体は拡張子から分かるとおり単なるテキストファイルなので、誰でも見ることが出来ますので、隠しページなどに使うと却ってみんなにばれてしまいます。

あくまでも検索エンジンのクローラーをコントロールするためだけに使用します。但し、必ず robots.txt に従うとは限りませんので、その点はご承知おき下さい。

詳しくは Search Console ヘルプの robots.txtの概要をご参照下さい。

# Group 1 User-agent: Googlebot Disallow: /nogooglebot/ # Group 2 User-agent: * Allow: / Sitemap: http://www.example.com/sitemap.xml

詳しくは Search Console ヘルプの robots.txt ファイルを作成するをご参照下さい。

必ずルートディレクトリに置きます。

ルートディレクトリというのはトップページと同じ場所になります。

このサイトで言うと「https://www.kanaya440.com/robots.txt」になります。

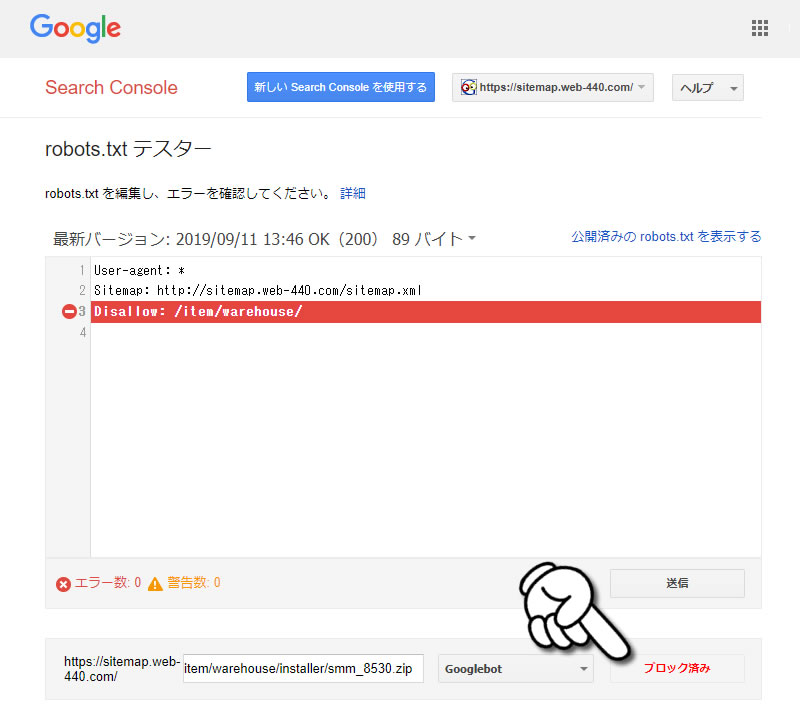

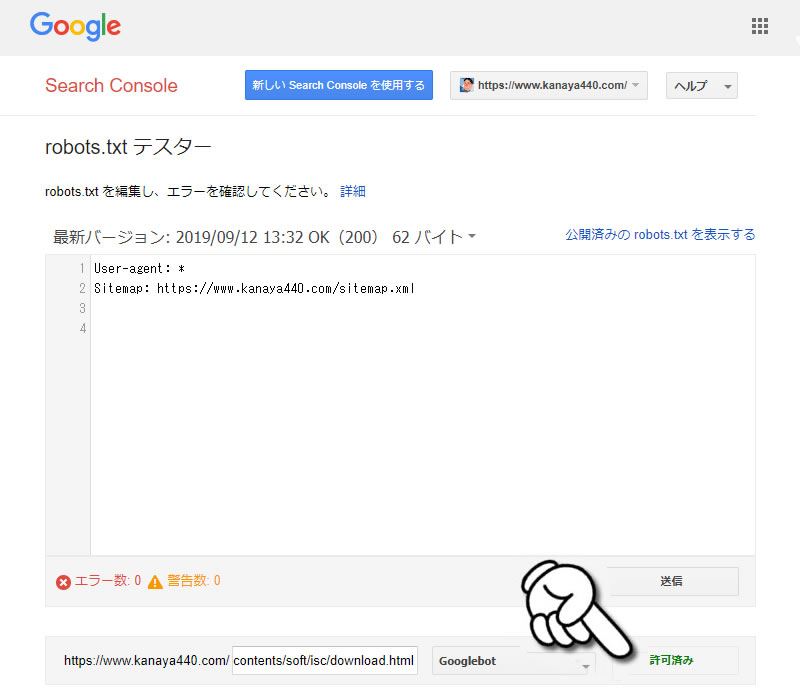

Search Console の robots.txt テスター で確認出来ます。

※ Search Console にサイトを登録する必要があります。

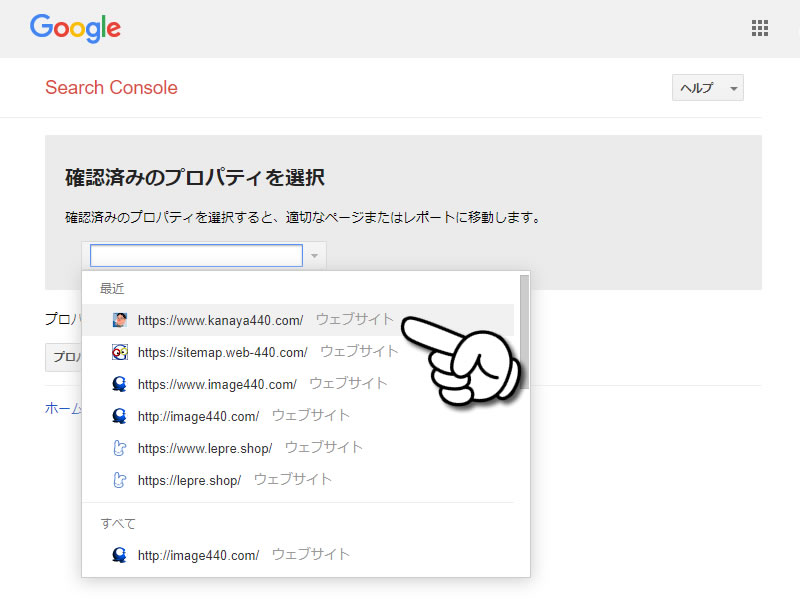

1.「プロパティを選択して下さい」をクリックする

2.調べるサイトを選択する

3.エラー数と警告数、及び詳細が確認出来ます。

4.URLを入力して「テスト」ボタンをクリックするときちんとブロックされているか確認出来ます。